-

مجاني + مدفوع

- زيارة الموقع

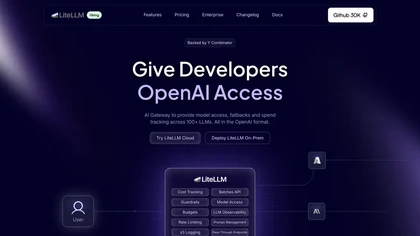

LiteLLM: مكتبة مفتوحة المصدر لتوحيد التعامل مع نماذج الذكاء الاصطناعي الكبيرة

مقدمة عن الأداة

مع الانتشار السريع لنماذج الذكاء الاصطناعي الكبيرة (LLMs)، أصبح المطورون يواجهون مشكلة حقيقية: كل مزود خدمة يملك API مختلفًا وطريقة مختلفة للاستدعاء والإعدادات وإدارة المفاتيح. هذا يعني وقتًا أطول في التهيئة، وتعقيدًا أكبر في الصيانة، وصعوبة في التبديل بين النماذج.

هنا تأتي مكتبة LiteLLM كحل عملي وبسيط، حيث توفر طبقة موحدة للتعامل مع مئات نماذج الذكاء الاصطناعي من مزودين مختلفين مثل OpenAI وAnthropic وCohere وAzure وغيرهم، باستخدام صيغة استدعاء واحدة فقط.

بمعنى آخر: بدل أن تتعلم 10 واجهات API مختلفة، تتعلم واجهة واحدة… وتستخدم أي نموذج تريده.

المكتبة مفتوحة المصدر ويمكن تثبيتها بسهولة عبر pip، وتتيح إجراء عمليات completion و embedding وتبديل النماذج وتتبع التكلفة وتفعيل fallback تلقائي عند فشل نموذج معين — وكل ذلك دون تعديل كبير في الكود.

المميزات الأساسية

1. توحيد استدعاءات نماذج الذكاء الاصطناعي

توفر LiteLLM تنسيقًا موحدًا مشابهًا لطريقة OpenAI، مما يسمح لك باستدعاء أي نموذج بنفس البنية تقريبًا، سواء كان من OpenAI أو Cohere أو غيرهما.

2. دعم أكثر من 100 نموذج

يمكنك التبديل بين النماذج بسهولة دون إعادة كتابة الكود أو تعديل المنطق البرمجي.

3. Completion و Embedding بسهولة

المكتبة تبسط استدعاء:

إنشاء النصوص

تحليل النصوص

إنشاء المتجهات Embeddings

وذلك عبر استدعاءات قصيرة جدًا.

4. التثبيت السريع عبر pip

إعداد المشروع يتم خلال ثوانٍ فقط دون إعدادات معقدة.

5. إعداد مفاتيح API عبر Environment Variables

يمكنك إدارة مفاتيح جميع المزودين بشكل منظم وآمن.

6. Load Balancing

توزيع الطلبات على عدة نماذج أو مزودين لتقليل التأخير وزيادة الاعتمادية.

7. Fallback تلقائي

إذا فشل نموذج معين، تنتقل الطلبات تلقائيًا إلى نموذج بديل دون توقف الخدمة.

8. تتبع التكاليف

ميزة مهمة للشركات — يمكنك معرفة تكلفة استخدام الذكاء الاصطناعي بدقة وإدارة الميزانية.

9. دعم GitHub وDocker والمجتمع المفتوح

المشروع مدعوم بمجتمع نشط ويُستخدم في ملايين الطلبات مع استقرار مرتفع.

الاستخدامات العملية

تطوير تطبيقات الذكاء الاصطناعي

بناء تطبيقات تعتمد على المحادثة أو التوليد النصي دون القلق بشأن مزود النموذج.

أنظمة الدعم الفني الذكية

إنشاء Chatbots تعمل حتى عند توقف أحد المزودين بفضل fallback.

تحليل البيانات

استخراج معلومات من النصوص وتحليلها باستخدام embeddings.

منصات SaaS

إدارة التكلفة والتحميل بين مزودين مختلفين لتقليل التكاليف التشغيلية.

التجارة الإلكترونية

إنشاء وصف منتجات تلقائي بلغات متعددة باستخدام نماذج مختلفة حسب السعر أو الجودة.

أنظمة التوصية والبحث الذكي

تحسين البحث الداخلي عبر embeddings الموحدة.

طريقة العمل

العمل باستخدام LiteLLM يتم عبر خطوات بسيطة:

تثبيت المكتبة

إضافة مفاتيح API في متغيرات البيئة

استدعاء النموذج عبر دالة موحدة

تغيير المزود أو النموذج دون تعديل الكود

النتيجة: كود أقصر + مرونة أعلى + تكلفة أقل.

لماذا تختار LiteLLM؟

توفير وقت التطوير

بدلاً من كتابة تكامل منفصل لكل مزود، تكتب مرة واحدة فقط.

مرونة التبديل بين النماذج

يمكنك اختبار عدة نماذج واختيار الأفضل بسهولة.

تقليل التكاليف

التبديل الذكي بين النماذج الأرخص والأسرع.

موثوقية عالية

fallback + load balancing = عدم توقف الخدمة.

مناسب للإنتاج Production Ready

مستخدم فعليًا في ملايين الطلبات بنسبة استقرار عالية.

الأسئلة الشائعة

هل LiteLLM مجاني؟

نعم، هو مشروع مفتوح المصدر ويمكن تشغيله محليًا أو استخدام الخدمة السحابية.

هل يدعم أكثر من مزود؟

نعم، يدعم عشرات المزودين وأكثر من 100 نموذج.

هل يمكن استخدامه في الإنتاج؟

نعم، يدعم تتبع التكلفة والتحميل والتبديل التلقائي.

هل يحتاج خبرة كبيرة؟

لا، الإعداد بسيط جدًا مقارنة بالتكامل المباشر مع كل مزود.

هل يمكن تتبع المصاريف؟

نعم، يوفر أدوات مراقبة التكلفة وإدارة الميزانية.

الخلاصة

تُعد LiteLLM واحدة من أهم الأدوات للمطورين الذين يعملون مع نماذج الذكاء الاصطناعي الحديثة، حيث تحل مشكلة التعقيد الناتج عن اختلاف واجهات البرمجة بين المزودين.

بدلًا من القلق حول أي نموذج تستخدم أو كيف تتعامل مع فشل الخدمة أو ارتفاع التكلفة، توفر لك المكتبة طبقة ذكية موحدة تدير كل ذلك تلقائيًا.

إذا كنت تبني تطبيقًا يعتمد على الذكاء الاصطناعي — خصوصًا تطبيقات SaaS أو Chatbots أو أنظمة تحليل النصوص — فإن استخدام LiteLLM سيجعل مشروعك أكثر مرونة واستقرارًا وأقل تكلفة.

باختصار:

LiteLLM ليست مجرد مكتبة… بل هي طبقة إدارة كاملة لنماذج الذكاء الاصطناعي في مشروعك.

أدوات مشابهة

Mistral AI

مجاني + مدفوع

Deepseek V3.2

مجاني