-

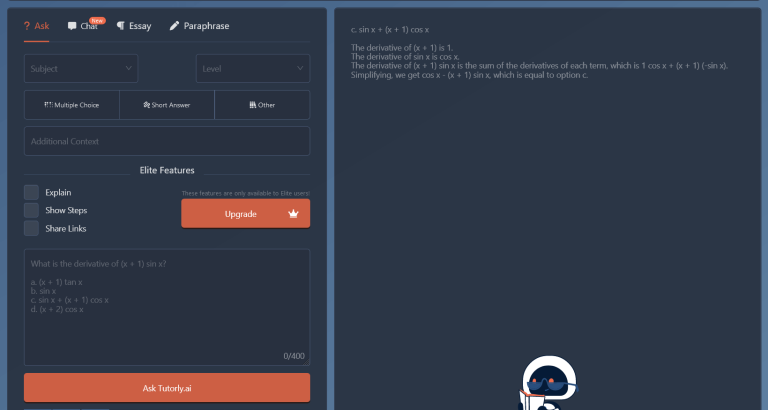

مجاني + مدفوع

- زيارة الموقع

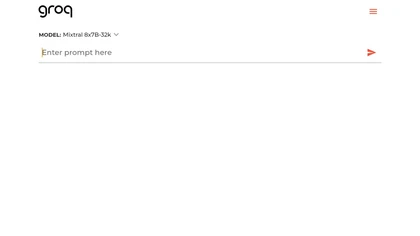

مقدمة عن تقنية Groq

مع انتشار تطبيقات الذكاء الاصطناعي التفاعلية مثل الشات بوت والترجمة الفورية والمساعدات الذكية، أصبح عامل السرعة أهم من أي وقت مضى. فالمستخدم اليوم لا يقبل الانتظار ثوانٍ طويلة حتى يحصل على رد من نموذج لغوي ضخم (LLM).

هنا تظهر شركة Groq التي تسعى إلى وضع معيار جديد لسرعة تشغيل نماذج الذكاء الاصطناعي عبر معالج مبتكر يُعرف باسم LPU – Language Processing Unit.

على عكس الاعتماد التقليدي على معالجات الرسوميات GPU، قامت Groq بتطوير شريحة مصممة خصيصًا لمهام الاستدلال (Inference) الخاصة بالذكاء الاصطناعي، مما يسمح بتوليد النصوص والاستجابات بسرعة شبه فورية.

ما هو LPU ولماذا هو مختلف؟

المعالج LPU ليس مجرد معالج أسرع… بل هو فلسفة مختلفة تمامًا في تصميم العتاد.

المشكلة في النماذج اللغوية التقليدية

نماذج اللغة الكبيرة (LLMs) تعاني من عنق زجاجة في نقطتين أساسيتين:

كثافة العمليات الحسابية

سرعة نقل البيانات من الذاكرة

في أنظمة GPU يتم تنفيذ العمليات بسرعة جيدة، لكن نقل البيانات بين الذاكرة والمعالج يسبب تأخيرًا كبيرًا.

الحل الذي قدمته Groq

قامت Groq ببناء معالج LPU بحيث:

يقلل الاعتماد على الذاكرة الخارجية

ينفذ العمليات بشكل تسلسلي عالي الكفاءة

يولد الكلمات بسرعة أعلى بكثير

والنتيجة:

عدد الكلمات في الثانية يرتفع بشكل ضخم مقارنة بالـ GPU والـ CPU

المميزات الأساسية لـ Groq

1) سرعة استدلال خارقة

تم تصميم النظام خصيصًا لتشغيل نماذج اللغة بسرعة فورية تقريبًا، وهو مثالي للتطبيقات التفاعلية المباشرة.

2) واجهة API لتشغيل النماذج

توفر Groq واجهة برمجية تمكن المطورين من تشغيل تطبيقات الذكاء الاصطناعي بسهولة عبر السحابة.

3) تسعير بنظام التوكن

الدفع يعتمد على عدد الكلمات المعالجة، مما يجعله مناسبًا للشركات الناشئة والتطبيقات المتغيرة الحمل.

4) تشغيل محلي On-Premise

يمكن شراء أجهزة LPU وتشغيل النماذج داخل الشركة دون الحاجة للسحابة.

5) أداء أعلى من GPU في LLMs

لأن الشريحة مصممة خصيصًا للغة وليس للرسوميات، فهي أكثر كفاءة في هذا النوع من المعالجة.

الاستخدامات العملية

1) تطبيقات الذكاء الاصطناعي اللحظية

مثل:

الشات بوت

الدعم الفني الفوري

المساعدات الذكية

الاستجابة تصبح فورية تقريبًا مما يحسن تجربة المستخدم.

2) تحليل البيانات النصية الضخمة

المؤسسات يمكنها تحليل ملايين الرسائل أو المستندات بسرعة كبيرة.

3) أنظمة خدمة العملاء

الرد على العملاء مباشرة دون تأخير ملحوظ.

4) أدوات كتابة المحتوى

صناع المحتوى يمكنهم توليد النصوص بسرعة كبيرة أثناء العمل.

لماذا تعتبر Groq مهمة في مستقبل الذكاء الاصطناعي؟

أغلب شركات الذكاء الاصطناعي ركزت على تحسين النموذج نفسه

أما Groq فركزت على طريقة تشغيل النموذج

الفرق يشبه:

تطوير محرك سيارة أسرع

أو بناء طريق بدون ازدحام

Groq اختارت الطريق الثاني.

الفئات المستفيدة من Groq

مهندسو الذكاء الاصطناعي

مطورو التطبيقات التفاعلية

شركات SaaS

المسوقون الرقميون

الباحثون التقنيون

مقارنة سريعة

| الجانب | GPU التقليدي | Groq LPU |

|---|---|---|

| سرعة الرد | جيدة | فورية تقريبًا |

| استهلاك الطاقة | مرتفع | أقل |

| مناسب للـ LLM | متوسط | ممتاز |

| التطبيقات اللحظية | محدود | مثالي |

الخلاصة

تقنية Groq لا تحاول جعل الذكاء الاصطناعي أذكى فقط…

بل تجعله أسرع لدرجة يشعر المستخدم أنه يتحدث مع إنسان حقيقي.

من خلال معالج LPU المخصص للغة، أصبح بالإمكان تشغيل تطبيقات ذكاء اصطناعي لحظية بدون تأخير، وهو ما يمثل خطوة كبيرة نحو مستقبل تعتمد فيه التطبيقات على التفاعل المباشر وليس الانتظار.

إذا كان المستقبل للذكاء الاصطناعي، فسرعته ستكون العامل الحاسم — وهنا تحديدًا تظهر قوة Groq.